Der Gesprächspartner muss auf jede unserer Fragen antworten. Anschließend bekommt er seine Antworten vorgelegt und kann sie autorisieren.

Zum journalistischen Leitbild von t-online.Friedensforscher erklärt Können Roboterwaffen einen "Krieg aus Versehen" auslösen?

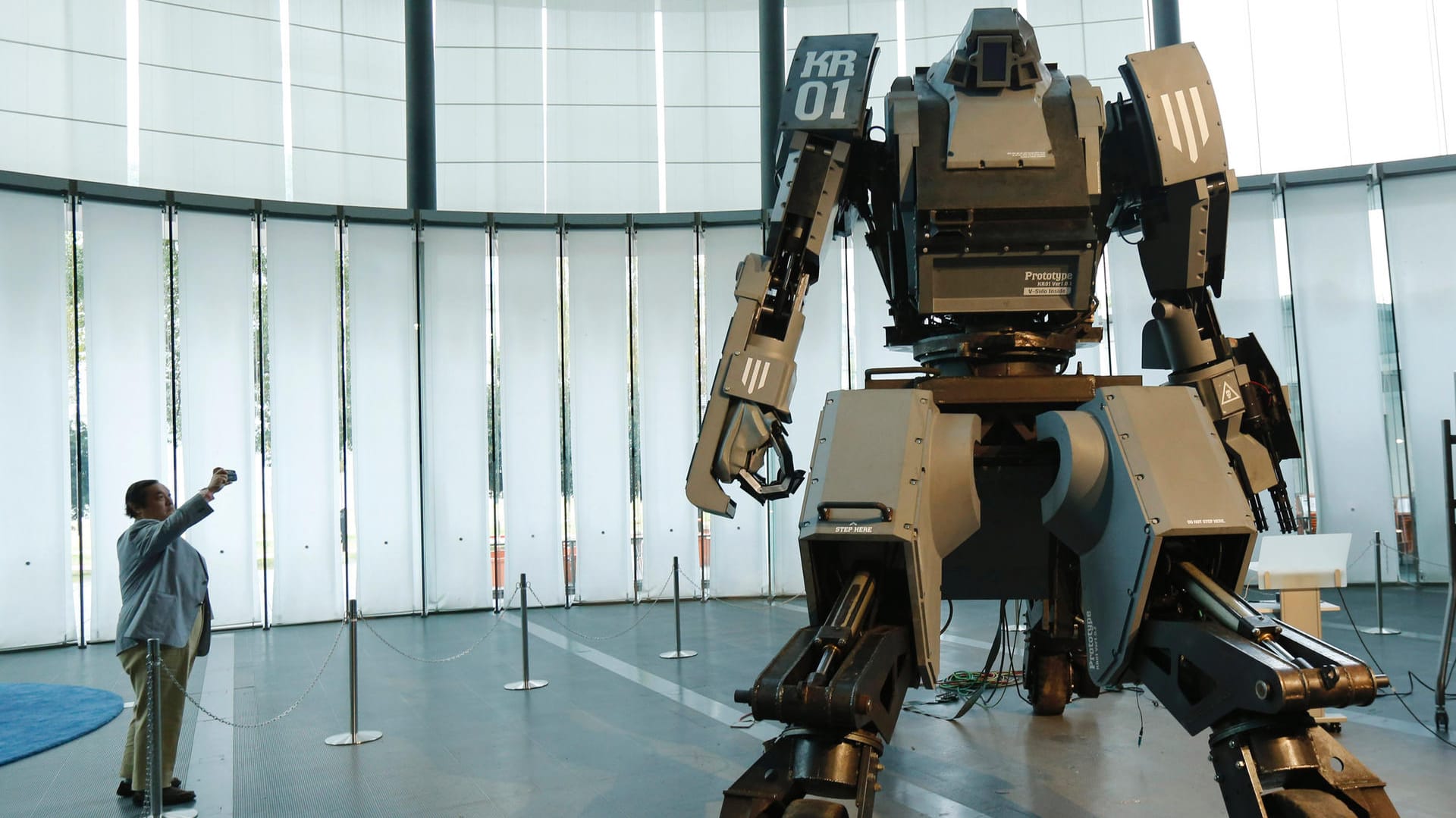

Autonome Waffen entscheiden eigenständig, wen sie angreifen. Einige Staaten treiben die Entwicklung auf diesem Feld voran. Doch zu welchem Preis? Der Friedensforscher Niklas Schörnig weiß, was schiefgehen könnte.

Dieses Interview erschien zuerst auf chrismon.de.

chrismon: Deutschland debattiert wieder darüber, ob die Bundeswehr ihre Drohnen bewaffnen sollte. Halten Sie das als Friedensforscher für sinnvoll?

Niklas Schörnig: Die Debatte um bewaffnete Drohnen für die Bundeswehr läuft schon über zehn Jahre, und alle Argumente sind ausgetauscht. Die Frage ist, ob man den Schutz, den solche ferngesteuerten Waffensysteme Soldatinnen und Soldaten im Einsatz bieten, höher gewichtet als mögliche Gefahren. Eine Befürchtung ist, dass sich die Politik schneller für einen militärischen Einsatz entscheidet, weil man "nur" Drohnen entsendet und keine Opfer fürchten muss. Ich bin kein Freund der bewaffneten Drohne, aber in Deutschland sind mögliche Risiken durch strenge Bundestagsmandate weniger ausgeprägt als in anderen Staaten.

Inzwischen haben über 30 Staaten bewaffnete Drohnen oder sind dabei, sie anzuschaffen. Ein Verzicht wäre also auch kein so starkes Signal mehr wie vor sieben, acht Jahren. Ich glaube, dass sich die Befürworter diesmal durchsetzen werden. Allerdings sollte die Bundesregierung klarstellen, wann die Drohnen zum Einsatz kommen sollen und dass man die amerikanische Praxis der gezielten Tötungen nicht nur ablehnt, sondern für völkerrechtswidrig hält.

Oft werden bewaffnete Drohnen im selben Atemzug wie sogenannte autonome Waffen genannt. Ist es dasselbe?

Nein, das sind unterschiedliche Systeme. Die bewaffneten Drohnen, über die aktuell geredet wird, sind ferngesteuert. Da entscheiden immer noch Menschen über den Waffeneinsatz. Zwar haben heutige Drohnen auch schon autonome Funktionen, zum Beispiel fliegen sie selbstständig Routen ab, ohne dass jemand den Steuerknüppel halten muss. Aber die kritischen Funktionen Zielauswahl und -bekämpfung, wie es im Militärjargon heißt, sind noch beim Menschen. Eine autonome Waffe wäre ein System, das sich seine Ziele selbst sucht, analysiert und über einen Waffeneinsatz entscheidet, ohne Menschen einzubeziehen. Zielt diese Waffe darauf, Menschen zu töten, sprechen wir von einem letalen autonomen Waffensystem.

Kritiker befürchten, dass autonome Waffen versehentlich Kriege auslösen könnten oder wir eines Tages von Killerrobotern angegriffen werden.

Solche Waffen gibt es noch nicht, bis auf ganz wenige Systeme, über deren Autonomie man streiten kann. Es gibt zum Beispiel auf Kriegsschiffen oder zum Schutz von Feldlagern automatische Geschütze, die anfliegende Raketen selbstständig erkennen und abschießen können. Autonome Waffen, die mobil sind und sich gegen Menschen richten, sind noch nicht eingeführt.

Niklas Schörnig, Jahrgang 1972, ist wissenschaftlicher Mitarbeiter im Programmbereich Internationale Sicherheit der Hessischen Stiftung Friedens- und Konfliktforschung (HSFK). Er forscht zu militärischer Robotik, dem Wandel des Krieges, gezielten Tötungen, Rüstungskontrolle und australischer Außen- und Sicherheitspolitik.

Viele Menschen denken, dass autonome Waffen bereits existieren, weil wir entsprechende technologische Fortschritte im Alltag sehen, etwa beim autonomen Fahren, der Bilderkennung oder Entscheidungshilfen beim Onlineshoppen. Science-Fiction-Filme spielen auch eine große Rolle. Aber es ist nicht so einfach, diese Technologien sicher und verlässlich zu einer Waffe zu kombinieren. Viele Staaten schrecken auch davor zurück, Systeme ins Feld zu führen, von denen sie nicht wissen, ob sie dem Völkerrecht entsprechen.

Das Völkerrecht hält Staaten davon ab, autonome Waffensysteme anzuschaffen?

Neue Kriegswaffen müssen nach Artikel 36 des ersten Zusatzprotokolls zu den Genfer Konventionen bestimmten Kriterien des humanitären Völkerrechts entsprechen. Sie dürfen zum Beispiel kein unnötiges Leid verursachen. Bei einem autonomen Waffensystem wäre etwa sicherzustellen, dass es zwischen Kombattanten und Zivilisten unterscheiden kann. Einige Informatiker glauben, dass Waffen das niemals schaffen werden.

Verstoßen autonome Waffen gegen die Würde des Menschen, weil sie sozusagen "gnadenlos" sind?

Einige Experten argumentieren genauso. Während ein menschlicher Soldat Gnade walten lassen kann, ein Gewissen hat und sich immer fragen muss, ob es nicht andere, nicht tödliche Optionen gibt, folgt die Maschine Algorithmen. Wer übernimmt die Verantwortung, wenn eine Waffe selbstständig tötet? Der einsetzende Offizier? Die Programmiererin? Der Verteidigungsminister oder die Präsidentin? Am Ende ist möglicherweise niemand verantwortlich.

Kollegen sehen deshalb die Würde der Menschen massiv verletzt, wenn sie von einer Maschine getötet werden. Man muss nur an die Selbstschussanlagen an der innerdeutschen Grenze denken, um das Argument nachvollziehen zu können.

Soldatinnen und Soldaten überzeugt dieses Argument meist nicht. Für sie ist die Vorstellung, schwer verwundet auf dem Schlachtfeld mit einem Bauchschuss dem Ende entgegenzusiechen, schlimmer, als von einem Kampfroboter zielgenau getötet zu werden. Wenn man die Berichte von historischen Schlachtfeldern liest, in denen sterbende Männer nach ihrer Mutter schreien – da sehe ich auch nicht besonders viel Würde, sondern nur schlimmes Leid und Elend. Insoweit bin ich bei der Beurteilung hin- und hergerissen, ob autonome Waffen die Menschenwürde mehr verletzten, als es das legale Töten im Krieg eh schon tut.

Können Maschinen überhaupt echte Entscheidungen treffen?

Man kann sich natürlich vorstellen, dass ein System mit sehr komplexen Wenn-dann-Regeln entscheidet, was ein Ziel ist und was nicht. Das System erkennt: Da auf dem Schlachtfeld ist ein Mann in einer Uniform, die die Insignien des Gegners hat. Der darf angegriffen werden. Das wäre eine relativ klare Entscheidung, die eine Checkliste abhakt und dann zum Ergebnis kommt: Ziel? Ja / nein.

Ob man das als eine "echte" Entscheidung bezeichnen würde, da mögen die Philosophen streiten, aber es ist zumindest möglich, dass das System aus der Checkliste eine Handlung ableitet. Manche Experten würden bei ausreichend komplexen Entscheidungsbäumen schon von künstlicher Intelligenz sprechen, andere nicht. Es ist aber auch vorstellbar, dass die "Entscheidung" auf verschiedenen Formen maschinellen Lernens basiert. Im Extremfall wäre ein System denkbar, das aus Bildern, Videos und Informationen selbst ableitet, wen es angreifen darf.

Was ist der Unterschied zwischen einer Checkliste und Maschinenlernen?

Wenn ich den Entscheidungsbaum in jedem Detail kennen würde, wüsste ich, wie das System reagiert – wen es angreift und wen nicht. Zumindest hinterher kann ich so rekonstruieren, wie das System die Entscheidung gefällt hat. Bei Maschinenlernen können selbst die Programmierer oft nicht sagen, warum ein System eine bestimmte Kategorisierung vornimmt. Es bezieht Statistiken und Faktoren ein, die wir Menschen überhaupt nicht auf dem Schirm haben. Es ist uns suspekt, wenn wir überhaupt nicht mehr wissen, wie die Entscheidung zustande kommt. Bei einem autonomen Waffensystem wäre es fatal, wenn plötzlich Verbündete oder Zivilisten angegriffen würden.

Wie weit ist die Technik, die die Bundeswehr einsetzt?

Die Bundeswehr hat das Flugabwehrsystem "Mantis", das man wohl in einen autonomen Modus schalten könnte. Das verbieten die Einsatzregeln der Bundeswehr aber zurzeit. Ein anderes Beispiel: Ein modernes Schiff der Bundeswehr kann ungefähr 400 Flugobjekte gleichzeitig beobachten und einschätzen, ob sie eine Gefahr darstellen. Und dann sagt ein System plötzlich: Diese drei Ziele müssen jetzt angegriffen werden, weil sie eine Gefahr sind! Da spielen viele Faktoren eine Rolle, die in einer angespannten Gefechtslage nicht mehr im Detail geprüft werden könnten. Wenn die Zeit knapp ist, muss man der Einschätzung des Systems vertrauen. Aber ein autonomes Waffensystem ist das noch nicht.

Weil noch ein Mensch dem Angriff zustimmen muss?

Ja. Bei der Bundeswehr muss ein Mensch einen Waffeneinsatz autorisieren, aber es wäre theoretisch denkbar und technisch möglich, dass dieser Schritt wegfällt. Die Frage ist, wie verlässlich und rechtssicher das System sein soll.

Wenn dieser Mensch keine zusätzlichen Informationen hat, wie oft würde er sagen: "Das ist mir zu heikel"? Auf welcher Basis soll er gegen ein hoch entwickeltes System entscheiden?

Es besteht das Risiko, dass sich der Mensch zu sehr auf das System verlässt. Ein Beispiel ist der Abschuss eines iranischen Airbus durch ein amerikanisches Kriegsschiff 1988 auf Basis einer Computerempfehlung. Da gehört schon sehr viel Mut dazu, seinem Bauchgefühl zu vertrauen und den Algorithmen zu widersprechen – besonders in Situationen, in denen Zögern den eigenen Tod bedeuten kann.

Aber auch da gibt es gute Beispiele. In den frühen 1980ern hat ein sowjetisches System fälschlicherweise eine Handvoll anfliegende Nato- Raketen "erkannt" und Alarm geschlagen. Dann war die Frage an den Offizier: Gibt er das weiter und leitet so einen massiven Gegenangriff ein? Aber der Offizier hatte Zweifel. Er dachte, wenn die Nato angreift, dann nicht mit so wenigen Raketen. Das ergibt strategisch keinen Sinn. Das System war aber nicht darauf programmiert, strategische Überlegungen in einen großen Kontext zu stellen, sondern es war programmiert: Könnte es eine Rakete sein, passen das Radarecho und die Geschwindigkeit? Und da passte anscheinend alles! Der Offizier hat sich aber zu Recht gegen das System entschieden. Hätte er nicht den Mut dazu gehabt, hätten wir möglicherweise einen Nuklearkrieg gehabt.

Könnte sich ein autonomes Waffensystem gegen den eigenen Befehlshaber wenden? Weil der Algorithmus ihn als Feind identifiziert?

Solche Systeme wird es nie geben, glaube ich.

Warum?

Es herrscht ein großer Streit unter Informatikern, ob eine allgemeine künstliche Intelligenz, also ein System, das das große Ganze sieht und nicht nur bestimmte Aufgaben bearbeitet, überhaupt je möglich ist. Aber es ist denkbar, dass ein System aufgrund strategischer oder taktischer Erwägungen dazu kommt, Ziele anzugreifen, die es für so wichtig hält, dass es Vorgaben ignoriert. Wenn neben einer Moschee ein Luftabwehrgeschütz steht, ist die Zerstörung der Moschee, obwohl eigentlich völkerrechtswidrig, in der komplexen Berechnung der Maschine vielleicht ein hinnehmbarer Schaden.

Wäre es möglich, Maschinen ethische Richtlinien einzuprogrammieren? Zum Beispiel: Kinder auf gar keinen Fall angreifen?

Der amerikanische Robotiker Ron Arkin arbeitet seit einigen Jahren an einer ethischen Kontrollinstanz in autonomen Waffen. Sie soll sicherstellen, dass ein System sich immer an Recht und Ethik hält und notfalls lieber die eigene Vernichtung in Kauf nimmt. Aber auch hier gibt es Probleme: Was, wenn ein System mit Kontrollinstanz auf ein feindliches System trifft, das keine hat? Macht es einen Unterschied, wenn da noch mal 10.000, 20.000 Zeilen Softwarecode durchlaufen werden müssen? Ich kann mir aber militärische Situationen vorstellen, in denen es auf diese minimale Zeit ankommt.

Das zweite Problem ergibt sich, weil das Völkerrecht nicht immer eindeutig ist, sondern offen für Interpretation. Möglicherweise gibt es dann unterschiedliche Programmierungen. Und natürlich könnten Diktatoren eine ethische Kontrollinstanz ausschalten.

Das Problem ist also weniger die technische Machbarkeit, sondern eher, dass sich eine Seite nicht daran hält?

Vertrauen zwischen Staaten ist schwer herzustellen und leicht zu beschädigen. Aber selbst, wenn man nur auf die Technik schaut, wird es kompliziert. Wenn ich mich mit Technikern unterhalte, kriege ich immer die Antwort: Dafür finden wir eine technische Lösung. Aber sie gucken immer nur auf ihr eigenes System. Ich habe Angst, dass so ein System trotz größter Vorsicht Völkerrecht bricht und Gräueltaten begeht.

- Künstliche Intelligenz: Wissenschaftler kontra "Terminator"-Projekt

- Kriege der Zukunft: So grausam werden sie durch KI

- Szenarien zur US-Wahl: "Zustände wie im Bürgerkrieg denkbar"

Wir können Systeme individuell kontrollieren und wundern uns nachher trotzdem, dass im Konfliktfall alles anders ist. Technische Fortschritte lösen nicht unbedingt strategische Probleme. Und dann gibt es noch unvorhersehbare Wechselwirkungen: Sie kennen Ihr System. Sie können vorhersagen, wie es sich verhält. Aber das trifft jetzt auf ein anderes System, dessen Softwarecode Sie nicht kennen. Was die beiden Systeme in der Interaktion für ein Ergebnis produzieren, ist nicht vorhersehbar. Man nennt das Emergenz.

Ein Beispiel?

Bei Amazon bieten Drittanbieter Bücher an. Die legen ihren Buchpreis anhand der Preise von anderen Händlern fest. 2011 gab es einen Zwischenfall mit einem Biologiebuch, das um die 40 Dollar kosten sollte. Plötzlich wurde es für knapp 24 Millionen Dollar angeboten, weil sich zwei Algorithmen gegenseitig beeinflusst und den Preis nach oben getrieben haben. Das Interessante daran ist, dass für jeden Anbieter der eigene Algorithmus zu 100 Prozent vorhersehbar war. Nur weil beide sehr schnell so aufeinander reagiert haben, wie es niemand erwartet hatte, ist der Preis so hochgegangen. Als Menschen das bemerkt haben, war die Situation schon eskaliert. Man stelle sich das bei autonomen Waffensystemen rivalisierender Staaten vor!

Dann hätten wir den "Krieg aus Versehen". Haben Sie Angst, dass uns eines Tages alles um die Ohren fliegt?

Die Leute, mit denen wir diskutieren, denken in Worst-Case-Szenarien, und auch ich bin dagegen nicht mehr immun. Die Gefahr ist real, dass die Entwicklung hin zu autonomen Waffen geht, die eigentlich niemand will. Hoffnung gibt mir aber, dass schon seit einigen Jahren auf UN-Ebene in Genf das Problem letaler autonomer Waffen intensiv diskutiert wird. Ob es zu einem völkerrechtlich verbindlichen Verbot kommen wird, wie es Nichtregierungsorganisationen fordern, oder "nur" zu politischen bindenden Verhaltensregeln, wie es die Bundesregierung vorschlägt, ist noch nicht abzusehen. Ich bin zuversichtlich, dass es zumindest zu einer gewissen Einhegung kommen wird.

Weiterlesen auf chrismon.de:

Der Mann, der die Welt rettete: 1983 meldete ein sowjetisches Überwachungssystem den Angriff amerikanischer Atomraketen. Der diensthabende Offizier, Stanislaw Jewgrafowitsch Petrow, reagierte besonnen – und verhinderte womöglich einen Atomkrieg.

Können Roboter auch fühlen? Unvorstellbar, sagt der Informatikprofessor Raúl Rojas. Trotzdem muss man die Visionen zu Ende denken, findet die Philosophin Thea Dorn.

Was, wenn der Roboter frech wird? Stecker ziehen hilft irgendwann auch nicht mehr, sagt Jürgen Schmidhuber. Er gilt als ein führender Entwickler der sogenannten Künstlichen Intelligenz.