Mehr als 150 Journalistinnen und Journalisten berichten rund um die Uhr für Sie über das Geschehen in Deutschland und der Welt.

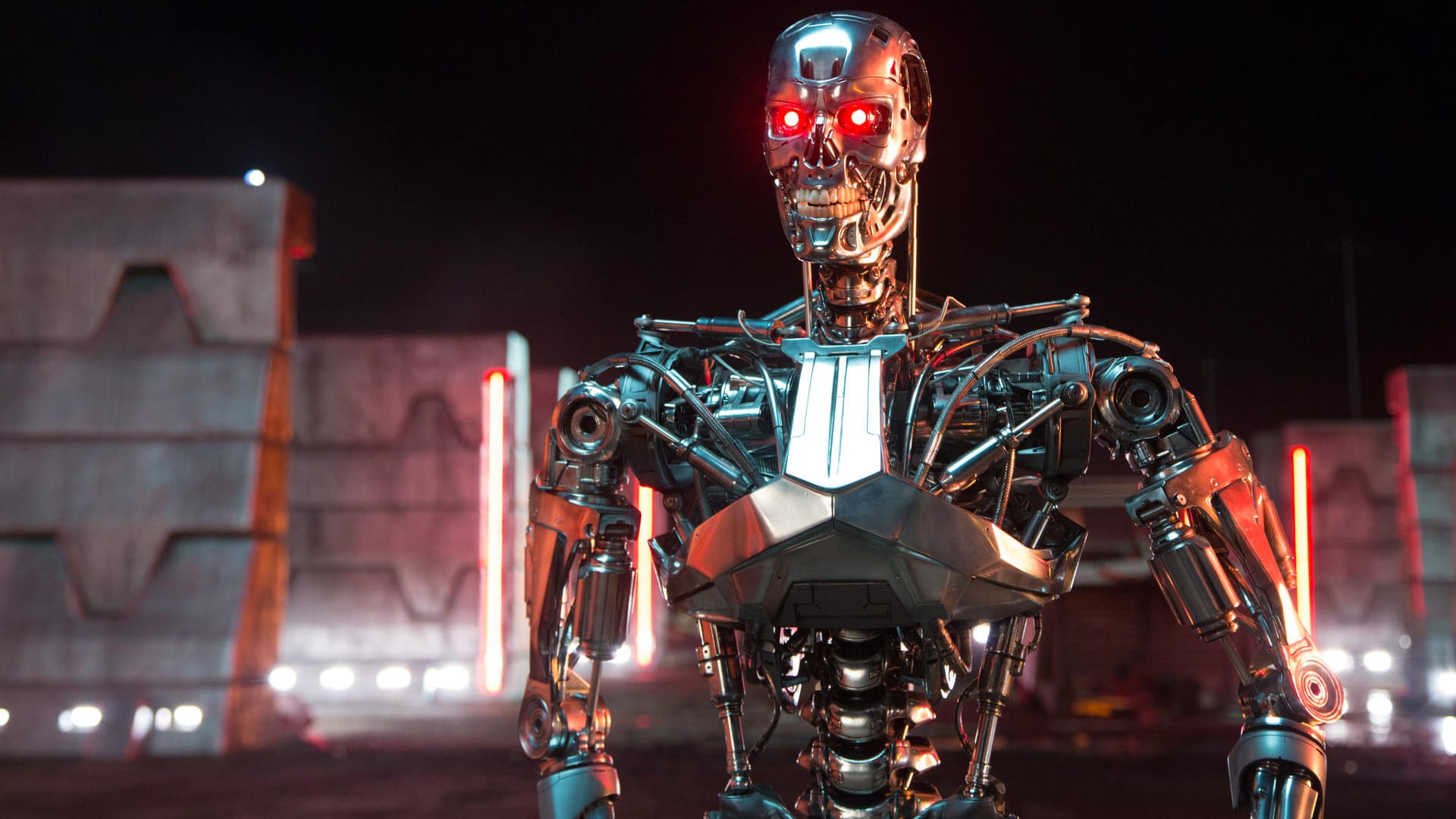

Zum journalistischen Leitbild von t-online.Waffen mit Künstlicher Intelligenz Wissenschaftler laufen Sturm gegen "Terminator"-Projekt

Südkoreanische Forscher wollen gemeinsam mit einem umstrittenen Rüstungskonzern Waffentechnologie mit Künstlicher Intelligenz verschmelzen. Das alarmiert jetzt weltweit Wissenschaftler.

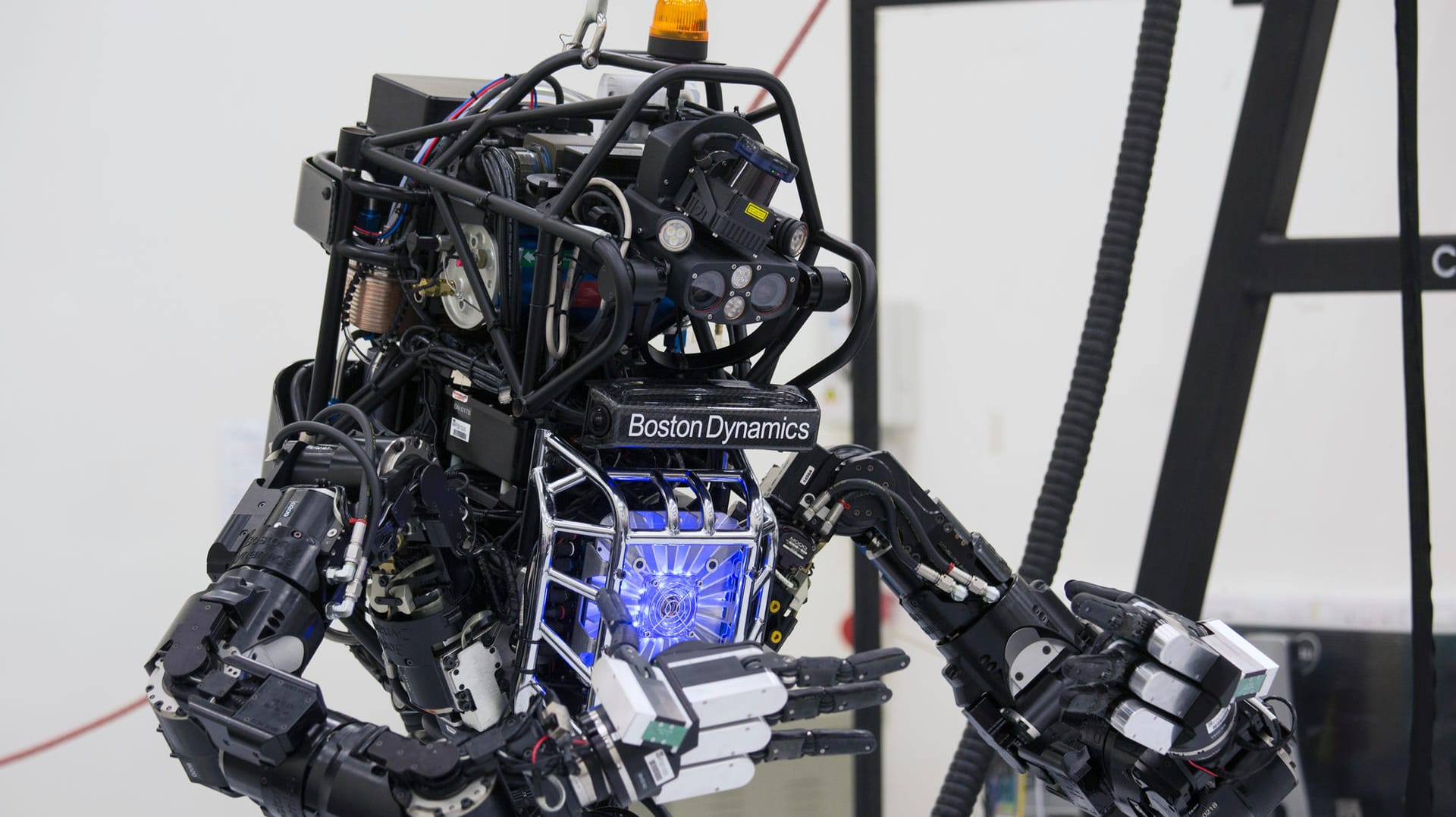

Es klingt wie eine Idee aus einem berühmten Hollywoodfilm: Ein Forschungslabor und eine Rüstungsfirma starten ein Projekt zur Entwicklung autonomer Waffen mit Künstlicher Intelligenz (KI). Diese Waffen sollen, wenn einmal einsatzbereit, ihre Ziele selbstständig suchen und anschließend eliminieren – ohne dass ein Mensch eingreifen muss. Internationale Experten laufen Sturm und warnen, solche Systeme könnten sich irgendwann jeglicher Kontrolle entziehen. Der "Terminator" lässt grüßen.

In Südkorea arbeiten derzeit Wissenschaftler an der Entwicklung genau solcher Waffen. Vor gut einem Monat präsentierten der Konzern Hanwha und die staatliche Forschungsuniversität KAIST ein gemeinsames Forschungsprojekt: das Research Center for the Convergence of National Defense and Artificial Intelligence – zu Deutsch: Forschungszentrum für die Konvergenz von Nationaler Verteidigung und Künstlicher Intelligenz.

Laut Mitteilung von Hanwha wollen die Südkoreaner mit dem Forschungsprojekt in den globalen Wettstreit in der Entwicklung autonomer Waffen einsteigen. Konkret geplant seien ein Kommandosystem, das auf Künstlicher Intelligenz basiert, ein Algorithmus zur Navigation unbemannter U-Boote, ein intelligentes Flugtrainingssystem, sowie ein autonomes Aufklärungs- und Erfassungssystem. Bereits am Jahresende sollen die gemeinsamen Studien abgeschlossen sein und konkrete Forschungsergebnisse vorliegen.

Wirksame Mechanismen menschlicher Kontrolle fehlen

Inzwischen aber wird der Aufschrei gegen das Projekt immer lauter. Wissenschaftler aus 30 Ländern haben zum Boykott der Universität in Daejeon aufgerufen. In einem offenen Brief an den Präsidenten der Hochschule, Sung-Chul Shin, erklären sie, bis auf Weiteres jede Zusammenarbeit einzustellen, solange KAIST nicht sicherstellen kann, dass die entwickelten Waffen wirksame Mechanismen menschlicher Kontrolle beinhalten.

Autonome Waffen, erklären die 50 Unterzeichner des Schreibens, würden es erlauben, Kriege in nie dagewesener Geschwindigkeit und bislang ungekanntem Ausmaß zu führen. Befreit von jeglichen ethischen Zwängen, könnten Despoten und Terroristen die Waffen gegen unschuldige Menschen einsetzen. "Wenn diese Büchse der Pandora einmal geöffnet ist", warnen die Forscher, "wird man sie kaum noch schließen können."

Mit KI ließe sich eine Reihe großartiger Dinge tun, die Leben retteten, auch im militärischen Kontext, sagte der Initiator des Boykotts, Toby Walsh, Professor an der Universität von New South Wales in Australien. "Aber öffentlich zu erklären, das Ziel sei die Entwicklung autonomer Waffen und das mit einem solchen Partner, beunruhigt mich sehr." Hanwha, Südkoreas größte Waffenschmiede, steht auch wegen der Herstellung von weltweit geächteter Streumunition in der Kritik.

Amerikaner und Russen entwickeln intelligente Waffen

Die Debatte um Künstliche Intelligenz in der Rüstungsindustrie ist nicht neu. Auch Länder wie die USA und Russland arbeiten an intelligenten Waffensystemen. Das Pentagon entwickelt derzeit einen Seezielflugkörper, der im Flug Kurs und Geschwindigkeit selbstständig anpassen und feindliche Radarsysteme erfassen kann. Ein ähnliches Projekt verfolgt auch Moskau.

Ein anderes Programm des US-Verteidigungsministeriums mit dem Namen "Wingman" zielt auf den Bau eines autonomen, bewaffneten Fahrzeugs, das einem Soldaten an die Seite gestellt wird. Der Soldat, so verspricht es das Pentagon, soll in letzter Konsequenz die Kontrolle über den Einsatz tödlicher Munition behalten.

Sorge vor dem Verlust menschlicher Kontrolle

Befürworter intelligenter Waffensysteme sagen, der Einsatz von KI könne helfen, Rüstungskosten zu drücken und zivile Opfer in Kriegen zu vermeiden. Kritiker hingegen warnen, die Entwicklung solcher Waffensysteme würde große kriegerische Konflikte nur heraufbeschwören. Sie befürchten einen Verlust menschlicher Kontrolle und fordern deshalb einen weltweiten Bann für autonome Waffen.

Bei einer internationalen Konferenz zu Künstlicher Intelligenz 2015 in Buenos Aires wiesen Wissenschaftler auf die Risiken hin, die sich allein aus der Forschung an solchen Systemen ergeben würden. Denn anders als nukleare Waffen, für deren Bau erhebliche finanzielle Mittel und schwer beschaffbare Rohstoffe notwendig sind, könnten intelligente Waffensysteme mit vergleichsweise geringen Ressourcen in Masse produziert werden. Sie würden auf Schwarzmärkten gehandelt und in die Hände von Terroristen und Diktatoren fallen können, und ließen sich für "Attentate, die Destabilisierung von Staaten, die Unterdrückung der Bevölkerung und gezielte Angriffe auf ethnische Gruppen einsetzen".

Eine Konferenz der Vereinten Nationen befasste sich im vergangenen November in Genf mit dem Thema. Doch auf mehr als eine Fortführung der Beratungen konnten sich die rund 100 teilnehmenden Länder nicht einigen. Appelle von Menschenrechtlern und Experten, rasch Regeln zu schaffen, bevor tödliche autonome Waffen einsatzbereit sind, prallten am Unwillen der waffenproduzierenden Staaten ab. Der Vorsitzende der Beratungen, der indische Botschafter Amandeep Gill, stufte die Debatte gar als hysterisch ein. "Man sollte die Sache nicht dramatisieren", sagte er. "Roboter werden nicht die Welt übernehmen."