Mehr als 150 Journalistinnen und Journalisten berichten rund um die Uhr für Sie über das Geschehen in Deutschland und der Welt.

Zum journalistischen Leitbild von t-online.Fake-Kampagne Künstliche Fotos: Computer macht die gute Miene für böse Trolle

Computergenerierte Fotos von Menschen, die es gar nicht gibt? Ein Wissenschaftler erklärt das Phänomen – und wie man sich weniger täuschen lässt.

t-online hat enthüllt, dass Fake-Videos und Fake-Artikel von einem Heer von Troll-Accounts mit täuschend echt aussehenden Fotos verbreitet werden. Facebook hat viele beteiligte Accounts bereits gelöscht, die anfangs sehr regen "Netflix-Frauen", die angegeben hatten, für den Streamingdienst zu arbeiten, spielen kaum noch eine Rolle. Auf Twitter läuft dafür eine neue Welle von Antworten mit Links zu gefälschten FAZ-Artikeln, und sie kommen vor allem von Frauen mit sympathisch wirkenden Fotos.

Doch die Menschen auf den Fotos gibt es nicht. Der Fall macht vielen Menschen erstmals richtig bewusst, dass Computer Porträtfotos erfinden können. Und diese Fotos sind immer häufiger zu sehen. Kann man nichts mehr glauben? Und wie verraten die Bilder sich – noch?

Forscher erkannte Fake sofort

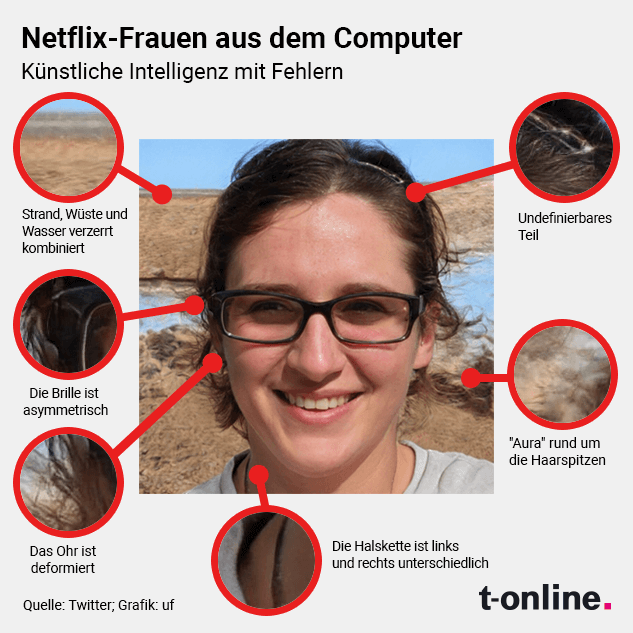

"Isabella Stein" ist einer der Accounts, der auf Facebook rege an der Kampagne beteiligt war, Stimmung gegen Russland-Sanktionen und gegen die Ukraine zu machen. "Isabella Stein" ist aber auch ein Beispiel für die Grenzen der Technik. Wer genauer hinschaut, kann im Bild diverse Fehler entdecken. Joel Frank hat sofort gesehen, dass ihr Porträt vom Computer generiert wurde.

Frank forscht an der Ruhr-Universität Bochum an Techniken zur Erkennung von Deep Fakes und hat Tausende der falschen Bilder gesehen. Die Wissenschaftler können sich aktuell nicht über mangelndes Interesse an ihrem Gebiet beschweren – zumal mit dem Gespräch eines vermeintlichen Wladimir Klitschko mit unter anderem der Berliner Bürgermeisterin Franziska Giffey das Thema Fakes großes öffentliches Thema war. Im März war auch ein Deep-Fake-Video aufgetaucht, in dem vermeintlich der ukrainische Präsident Wolodymyr Selenskyj sein Volk aufforderte, die Waffen niederzulegen.

Frank ist beteiligt an der Entwicklung einer Methode, die Bild- und Ton-Fakes identifizieren kann. Erstellt man eine Frequenzanalyse eines Bildes, dann wird so bislang eine typische Gitterstruktur sichtbar, die den Algorithmus verrät, der das Bild erstellt hat. Zum Teil gehen solche Merkmale verloren, wenn Bilder in Netzwerke hochgeladen und dabei von Facebook, Twitter & Co. verkleinert werden. "Unsere Genauigkeit bei der Erkennung sank von mehr als 99 Prozent auf etwa 95." Um die Spuren wirksam zu verwischen, müsste also jemand mehrere Techniken kombinieren. Und Netzwerke wie Facebook verfügten auch mit ihren Datenmengen und Ressourcen über noch ganz andere Möglichkeiten, Manipulation zu identifizieren.

Der Druck dürfte auch wachsen. Zwar ist es zulässig, ein Fake-Bild zu nutzen. Es gibt sogar eine Seite namens "This person does not exist", die für jeden kostenlos Bilder generiert. "Das hat aber Folgen: Es ist einfach, für eine Fake-News-Kampagne per Knopfdruck neue Bilder zu erzeugen, um 200 Accounts zu erstellen", sagt der Computerwissenschaftler. Selbst die Bilder der "Netflix-Frauen" für die Fake-Kampagne könnten von dort stammen.

Software rechnet mit Durchschnitt

Und irgendwer sitzt garantiert daran, ein Schlupfloch gegen das Entdecken zu finden – also Technik, gegen die die bisher bekannten Methoden wirkungslos sind. "Das ist wie immer in der Security ein ewiger Wettlauf."

Doch wie entstehen die Bilder überhaupt? Anhand eines großen Datensatzes echter Bilder lernt Künstliche Intelligenz, wie ein Gesicht durchschnittlich aussieht. Dazu ist eine enorme Menge an Fotos von echten Gesichtern nötig, anhand derer die Software gelernt hat, wie Gesichter im Schnitt aussehen. Beginnend von den Augen wird dann ein Gesicht errechnet.

Weil beim Trainingsdatensatz die Augen alle am gleichen Ort waren, baut der Rechner Bilder systematisch genauso auf. Und das hilft umgekehrt auch bei der Entdeckung. Die Erweiterung "Fake Profil Detector" für den Chrome-Browser erkennt Fakes bisher mit hoher Zuverlässigkeit, berichtet das "foto-Magazin".

Die Art des Aufbaus führt auch dazu, dass bei vielen Profilfotos aus der Künstlichen Intelligenz auf Facebook die untere Gesichtshälfte angeschnitten ist – die computererzeugten Bilder geben keinen anderen Ausschnitt her. Auch das ist oft schon ein gutes Indiz.

Was der Software auch noch Probleme macht: Beim Erstellen der Fotos "weiß" die Künstliche Intelligenz zwar, dass rechts und links vom Gesicht im Durchschnitt eine Fläche anzulegen ist, die Menschen dann als Ohren erkennen. Sie weiß auch, dass die Fläche von Strukturen verdeckt sein kann, die wir als Haare identifizieren. Doch beide Kopfseiten sind oft nicht konsistent.

Unterschiedliche Ohrläppchen

Im Ergebnis haben Ohrläppchen rechts manchmal eine andere Form als links. Ohrringe sehen unterschiedlich aus oder hören in der Hälfte auf, weil die Software eine durchschnittliche Ohrringfläche erstellt hat.

Bei "Isabella Stein" ist die Kette um den Hals auf der einen Gesichtshälfte ganz anders als auf der anderen. Die Brille sieht auch am einen Bügel anders aus als am anderen. Zudem gibt es in ihren Haaren etwas, was an eine Spange erinnert, aber auch ein Fehler in der Berechnung ist. Am häufigsten seien Fehler an den Übergängen zum Hintergrund. Im Fall von Isabella Stein kommt noch hinzu, dass der Hintergrund überhaupt keinen Sinn ergibt.

Die zugrunde liegende Technik dahinter, sie nennt sich Style-Gan, ist inzwischen in der dritten Generation angekommen. Bilder von "This Person does not exist" beruhen noch auf Version 2. Es werde auch nicht mehr lange dauern, bis derartige Fehler auch für geübte Nutzer mit dem bloßen Auge nicht mehr zu erkennen sind. "Dann wird für künstliche Intelligenz die nächste Herausforderung sein, Menschen in bestimmten vorgegebenen Situationen zu zeigen, also mehr Vorgaben zu machen."

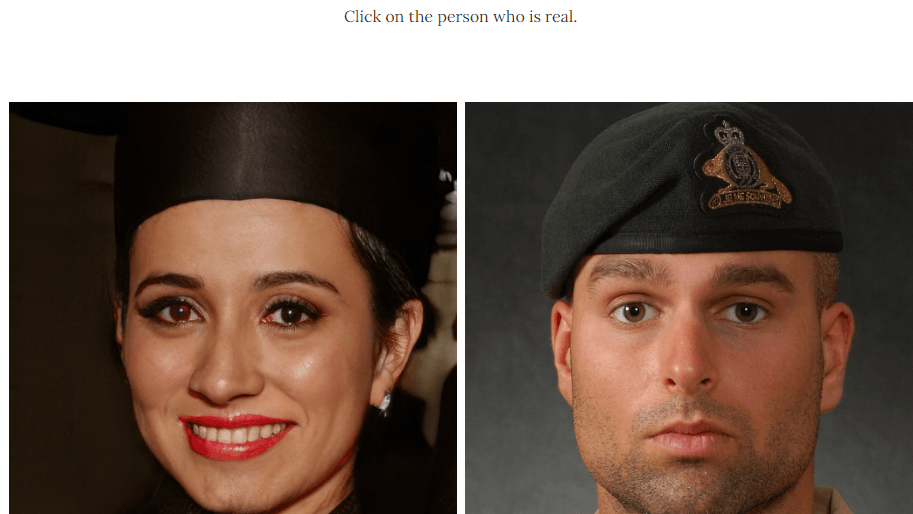

Bis dahin können Nutzer allerdings auch auf einer Seite "Which Face is real" testen, wie gut sie die computergenerierte Fotos erkennen. Allerdings kann das auch wieder eine Methode sein, Computer zu trainieren, welche Fakes gut erkannt werden und welche nicht – um noch echtere Porträts zu erzeugen.

Für manche der Troll-Accounts ist das aber alles egal: Bei der aktuellen Kampagne werden auch für "Selina" und "Runa" aus Deutschland fremde Bilder aus dem Instagram-Account eines Moskauer Kosmetikstudios genutzt.

- Telefonat mit Joel Frank

- Ruhr-Universität: Fake-Bilder anhand von Frequenzanalysen erkennen

- fotomagazin.de: Browser-Plugin erkennt Fake-Bilder

Quellen anzeigen