Der Gesprächspartner muss auf jede unserer Fragen antworten. Anschließend bekommt er seine Antworten vorgelegt und kann sie autorisieren.

Zum journalistischen Leitbild von t-online.Virtuelle Menschen Der künstliche Therapeut aus dem Computer

Schon in naher Zukunft könnten virtuelle Computerpersonen Teil unseres Alltags werden – und eine Hoffnung für Millionen von einsamen Menschen, berichtet Forscher Chaehan So.

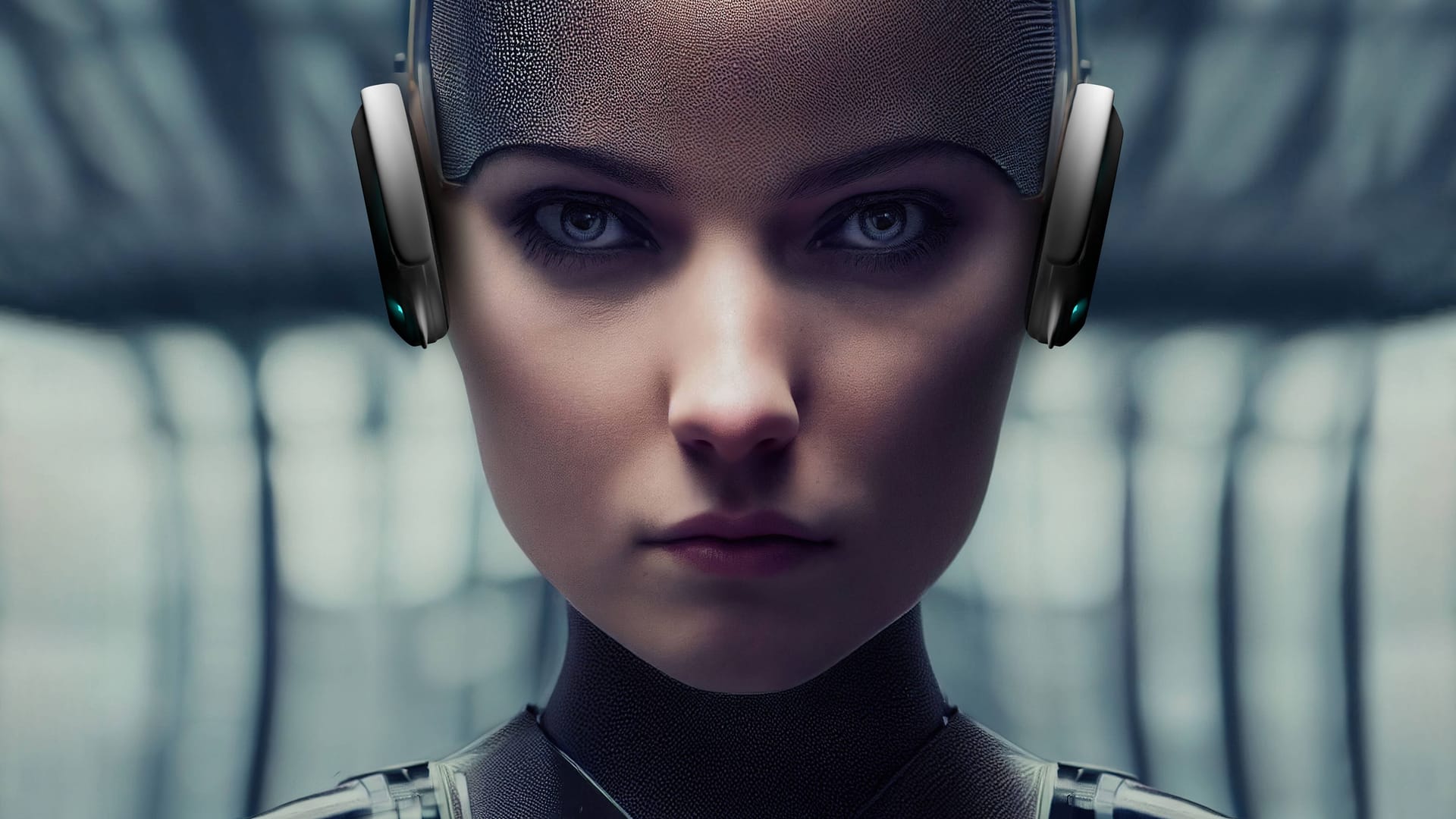

Beim Thema Künstliche Intelligenz (KI) oder englisch Artificial Intelligence (AI) denken die meisten Menschen noch immer an Beispiele aus Science-Fiction-Filmen. Meist handelt es sich dabei um eher unangenehme Zeitgenossen: Skynet etwa, die Computerintelligenz aus den Terminator-Filmen, die die Menschheit per Atomkrieg wegrationalisiert, oder Hal 9000, die Schiffsintelligenz aus Stanley Kubricks Klassiker "2001 – Odyssee im Weltraum", die Teile der Besatzung umbringt.

Diese Darstellung von KI sei natürlich großer Quatsch, sagt Chaehan So. Der KI-Experte forschte in den vergangenen Jahren insbesondere daran, wie Menschen mit ersten Formen von "Virtual Beings", also quasi computergenerierten Personen, interagieren.

t-online: Sie haben die Wirkung von virtuellen Gesichtern erforscht. Wie wichtig wird für das Metaverse sein, dass Mimik und Gestik dieser Avatare wirklich echt aussehen?

Chaehan So: Es ist wirklich eine sehr entscheidende Frage und es gibt da zwei wichtige Anhaltspunkte. Der erste ist das sogenannte CASA-Modell, das steht für Computers Are Social Actors. Und auf diesem Modell beruht ganz viel Forschung im Bereich der Mensch-Maschine-Interaktion. Hier hat man herausgefunden, dass Menschen im Wesentlichen auf Virtual Beings ähnlich reagieren wie auf andere Menschen. Deswegen werden Computer wie soziale Akteure wahrgenommen.

Chaehan So ist Gründer der kalifornischen Nonprofit-Organisation Virtual Friend. Sie widmet sich der Frage, wie Virtual Beings Menschen mit sozialer Angststörung helfen können. Chaehan So war 2016–2022 Professor für Information Design und Artificial Intelligence in Südkorea und davor 13 Jahre in der Industrie tätig. Er ist in seiner Ausbildung stark interdisziplinär geprägt als Diplom-Ingenieur (TU Berlin), Diplom-Kaufmann (Ecole Supérieure de Commerce de Paris) und Doktor der Psychologie (Humboldt-Universität Berlin).

Menschen nehmen solche Virtual Beings also ähnlich wie andere Menschen wahr?

Ganz genau. Nur ein paar Beispiele: Der erste Eindruck funktioniert überraschend ähnlich. Menschen schließen daraus Persönlichkeitsmerkmale, wie sie auch normale Menschen haben. Die Forschung misst da etwa die Vertrauenswürdigkeit, Menschenähnlichkeit oder auch Sympathie und Empathie. Und aufgrund dieser Urteile bilden sie dann auch eine Beziehung. Die Wahrnehmung eines solchen Virtual Beings funktioniert in ein paar Bereichen etwas anders – aber im Wesentlichen werden hier genauso die Gesichtszüge wahrgenommen und sich dann darüber ein Urteil gebildet. Die Ähnlichkeit zum Menschen spielt dabei eine große Rolle, einige Abweichungen – etwa sehr große Augen – werden dabei aber akzeptiert.

Ist eine gewisse Comic-Haftigkeit dabei auch wichtig? In der Forschung gibt es ja auch die Beobachtung des "Uncanny Valleys" – wo ausgerechnet eine besonders hohe, aber nicht perfekte Ähnlichkeit zum Menschen den Betrachtern eher unheimlich statt sympathisch erscheint.

Eben das stellt eine Schwierigkeit dar. Entweder sollen die Virtual Charakters sehr realistisch aussehen oder ganz klar cartoonhaft. Aber wenn sie realistisch sind, dann sorgen schon ganz kleine Abweichungen von der realistischen Darstellung – komische Gesichtszüge zum Beispiel oder leicht verschobene oder verlängerte Augen – für den gegenteiligen Effekt: Statt vertraut wirken diese fast menschlichen Darstellungen eher abschreckend.

Jetzt ist die Frage der realistischen Darstellung ja nur ein Teil eines glaubhaften virtuellen Wesens. Wie weit ist die AI-Technologie denn mittlerweile damit, solch ein Virtual Being auch überzeugend lebendig reagieren und antworten zu lassen?

Ich habe eigentlich alle AI-Konversations-Modelle getestet – und nichts davon funktioniert so, dass man sich als Gegenüber wirklich verstanden fühlt. Für mein Experiment habe ich das meiner Meinung nach beste Modell benutzt. Und tatsächlich habe ich da manchmal den Eindruck gehabt, dass mich jemand versteht – manchmal aber auch nicht. Aber dass es diese Momente überhaupt gibt, ist schon beachtlich. Da kann man wirklich sehen: Es gibt Fortschritt und der passiert immer schneller. In fünf Jahren wird das schon eine Qualität haben, die beachtlich ist. Nicht so gut, dass sich Menschen jetzt direkt in dieses virtuelle Gegenüber verlieben wie in dem Film "Her" –, aber immerhin gut genug, dass diese Konversationsmodelle einen echten Nutzen haben werden. Für viele Menschen, die unter Einsamkeit und in der Folge an Depressionen leiden, könnte das wirklich schon helfen.

Und wie sieht es mit funktionalen Rollen wie Kundenberater aus? So was dürfte doch schon bald über solche Modelle umsetzbar sein, oder?

Ja, das wird in diesem Bereich schon heute sehr stark genutzt, weil das eine Art von sprachlicher Interaktion ist, die sich sehr leicht simulieren lässt. Da braucht man oftmals nicht mal AI dafür, das klappt auch durch einfache, regelbasierte Modelle. Ich werde oft gefragt, ob ich denn nicht irgendwas für die Industrie entwickeln möchte. Ich lehne das immer ab – das ist das Uninspirierendste, das man sich vorstellen kann. Dafür muss ich keine Forschung machen.

Vielleicht sollten wir an dieser Stelle noch einmal kurz über die Begrifflichkeiten sprechen. Was ist denn ein Virtual Being? Etwa zum Unterschied zu einem Avatar?

Ein Virtual Being ist aus meiner Sicht die Visualisierung von einem virtuellen Charakter, der auch sprechen kann. Das dann aber auf eine Weise, dass auch menschliche Züge wie Empathie hervortreten. Also wenn ich sage, ich habe mir das Knie verstaucht, dann sollte dieses Virtual Being nicht sagen: "Okay, geh zum Doktor", sondern: "Oh, das tut mir leid. Das muss aber wehgetan haben." Und erst das macht es dann zu einem Virtual Being, weil ich mich ihm gegenüber auch öffnen und anvertrauen kann. Die typische Hollywood-Erzählung von Künstlicher Intelligenz ist aber meistens eine ganz andere. Da verliebt sich die AI dann in einen Menschen, wird vom ihm schlecht behandelt, ist dann gekränkt und beschließt Rache zu nehmen, die Menschheit zu vernichten oder so etwas. Immer übermannen menschliche Gefühle die AI und das führt dann zur Katastrophe. Das macht mich wahnsinnig.

Aber wie sollten wir uns denn dann die Zukunft der AI vorstellen?

Meine Vision ist, dass solch eine AI irgendwann so gut wird, dass sie Menschen soziale Fähigkeiten beibringen kann, die diese verloren haben, weil sie zu viel am Smartphone hängen oder zu viel gamen. Und das hat mich dazu getrieben, diese Forschung zu machen. Ich habe sozusagen ein Virtual Being gebaut. Also ein AI-erzeugtes menschliches Gesicht, das entsprechend über Mimik verfügt und dahinter geschaltet das derzeit beste Konversationsmodell. Und mit diesem Virtual Being konnte man sich dann über Zoom unterhalten – wie bei einem ganz normalen Video-Call.

Und wie lief das Experiment ab?

Ich habe über fünf Tage hinweg die Studienteilnehmer immer wieder zehn Minuten mit dem Virtual Being sprechen lassen. Meine Hoffnung war, dass die Teilnehmer sich in den Gesprächen dann zunehmend öffnen würden und auch über eigene Probleme sprechen. Leider hat sich der Effekt nicht eingestellt. Die meisten Teilnehmer haben das Virtual Being einfach nur getestet. Aber es gab ein paar wenige, die haben tatsächlich interessante Gespräche geführt und gefragt, was passiert, wenn wir sterben oder wie sie nach einer Trennung andere Menschen kennenlernen können? Es ging teilweise auch um philosophische oder religiöse Fragen. Die Antworten waren nie komplett unsinnig. Das finde ich bemerkenswert, denn im Gespräch mit Menschen erhält man oft unsinnige Antworten.

Wir benötigen Ihre Einwilligung, um den von unserer Redaktion eingebundenen Youtube-Inhalt anzuzeigen. Sie können diesen (und damit auch alle weiteren Youtube-Inhalte auf t-online.de) mit einem Klick anzeigen lassen und auch wieder deaktivieren.

Wie war die Reaktion der Teilnehmer?

Die meisten waren vom Aussehen eher enttäuscht. Überrascht hat viele aber, dass sie in der Interaktion so etwas wie menschliche Wärme wahrgenommen haben. Und tatsächlich hat das von mir genutzte Konversationsmodell genau hier einen Schwerpunkt. Die Vermittlung von menschlicher Wärme lässt sich also gezielt als Effekt erreichen. Das ist für mich tatsächlich ein wichtiges Ergebnis – da sind wir einen entscheidenden Schritt weitergekommen. Allerdings sind wir noch längst nicht perfekt. Was etwa ganz klar gefehlt hat, ist eine Form von Gedächtnis. Denn aktuell kann sich das Virtual Being nicht an die Inhalte zurückliegender Gespräche erinnern.

Gibt es so was denn noch gar nicht?

Ja, man könnte meinen, dass es das bei manchen AI-Modellen schon gegeben hätte – aber wenn man dann ganz genau hinschaut, dann haben da immer Forscher nachgeholfen und händisch gewissermaßen Antworten platziert. Dass ein Konversationsmodell sich tatsächlich an ein vorangegangenes Gespräch erinnert, das gab es einfach noch nicht bis 2021, als ich mein Forschungsprojekt durchführte.

Ist das technisch denn so schwierig umzusetzen? Oder hat es bislang nur niemanden ausreichend interessiert?

Ich glaube beides. Der letzte Stand ist, dass im vergangenen Jahr ein neues Modell herausgekommen ist, das angeblich ein Gedächtnis hat. Aber ich habe es getestet und es hat nicht funktioniert. Und das ging auch etlichen anderen so. Das heißt nicht, dass eine der großen Firmen wie Google, Facebook, Amazon oder Apple das nicht schon intern konnte. Aber frei verfügbar, auf Open-Source-Basis, gab es das noch nicht bis zu diesem Jahr. Im Sommer wurde von Meta ein neues Modell angekündigt, dass sich angeblich erinnern kann: BlenderBot 3. Die Frage ist, ob das nicht nur technisch ein Erinnerungsvermögen aufweist, sondern sich aus der Sicht eines Menschen spürbar erinnern kann an subjektiv wichtige Gesprächsinhalte. Das werde ich in den nächsten Monaten testen.

Ihre Forschung hat jetzt noch am Bildschirm stattgefunden. Angenommen, man würde dasselbe Experiment per VR-Brille im virtuellen Raum stattfinden lassen, also ähnlich wie im Metaverse: Glauben Sie, dass das noch mal einen wesentlichen Einfluss auf die Wahrnehmung der Virtual Beings hätte?

Also der Immersionseffekt ist in VR sicherlich größer. Aber ich habe ja mal mit einem anderen Forscher zusammengearbeitet, der den Teilnehmern VR-Brillen aufgesetzt hat. Bei denen haben wir schon nach 10 Minuten Schwindelgefühl gemessen. Das ist natürlich ein Nachteil. Einerseits ist der Immersionseffekt größer, andererseits steigt das Schwindelgefühl. Ich weiß nicht, ob Leute dann wirklich langfristig in dieser VR-Welt bleiben. Ich glaube auch, dass die Perfektion der Darstellung im Vergleich zur Qualität des Inhalts nachrangig ist. Deswegen arbeite ich nicht in VR und konzentriere mich hauptsächlich darauf, die Qualität der Interaktion selbst zu steigern, weil das aus meiner Sicht mehr Relevanz für die Tiefe der Beziehung zwischen Mensch und Virtual Being hat.

Spielt Attraktivität eigentlich auch für Virtual Beings eine Rolle?

Ja, in meinen Experimenten zeigte sich ein Attraktivitätsstereotyp unerwartet klar. Es nennt sich "What is beautiful ist good" und bedeutet, dass wir attraktive Menschen grundsätzlich als besser einschätzen. Es war für mich überraschend, wie stark dies bei Menschen verankert ist, sodass es genauso bei virtuellen Wesen funktioniert. Es war also sehr wichtig, dass diese virtuellen Gesichter sehr attraktiv waren. Das hat dann zu mehr Interaktionen geführt und zu mehr Vertrauen. Eigentlich traurig, aber es ist genauso wie bei Menschen.

Sie haben sich in ihrer Forschung auch damit beschäftigt, welchen Einfluss Mimik, Kopfhaltung und weitere Parameter noch darauf haben, für wie kompetent man sein Gegenüber hält. Könnte ein hier optimiertes Virtual Being dadurch in manchen Bereichen letztlich viel effektiver sein, als es die meisten Menschen zu sein scheinen?

Als Lehrer oder Coach kann ich mir das durchaus vorstellen – wenn die Voraussetzung gegeben ist, dass ich von diesem Virtual Being auch wirklich etwas lernen will. Sogar als Psychologe wäre ein Virtual Being denkbar. Nicht unbedingt in der Psychotherapie, sondern eher so wie in den USA. Da ist ein Psychologe eher jemand, der ein bestellter Freund ist, der sehr gut zuhört. Also wenn ich jemand bin, der bis spät in die Nacht arbeitet und dann vor einem Vortrag am nächsten Tag Angst hat, kann ich selbst um ein Uhr nachts noch mal zehn Minuten über diese Angst sprechen. Das ist doch wunderbar. Solche Anwendungen sind halt nicht so geschäftsrelevant, deswegen redet niemand darüber. Persönlich glaube ich aber, dass solche Anwendungsbereiche sehr wichtig werden.

Könnten Ihrer Meinung nach Virtual Beings auch eine Art psychologische Ersthelfer bei Angststörungen sein?

Ja, das glaube ich. Und der Bedarf ist hier wirklich hoch: Ich habe die Zahlen jetzt nicht ganz genau parat, aber etwa jeder dritte Erwachsene wird im Leben irgendwann mal an einer Angststörung leiden. Das Entscheidende bei so einem Virtual Being ist dann genau das, was man heute noch als Unzulänglichkeit auslegt: Eben weil es kein echtes Wesen ist und nicht wirklich mitfühlen kann, trauen sich viele Menschen, sich zu öffnen und über ihre Ängste zu sprechen.

Tatsächlich?

Ja, diese Öffnung hat man gerade bei eher stigmatisierten oder schambehafteten Themen messen können. Da ging es in einem Experiment etwa um Sexualkrankheiten. Generell ist die Konsultation eines Psychologen ja ebenfalls stigmatisiert. Gegenüber einem Virtual Being öffnen sich die Menschen da eher, weil sie keine Angst haben müssen, von ihrem Gegenüber verurteilt zu werden. Früher sind die Leute in die Kirche zur Beichte gegangen. Aber das ist ja immer weiter verschwunden in der Gesellschaft – und diese Lücke kann die AI Technologie dann füllen.

Jetzt sagten Sie, dass die Technologie bereits in fünf Jahren einsatzfähig sein könnte. Wie sieht das denn mit dem Anwendungsumfeld aus? Wäre in fünf Jahren denn auch denkbar, dass solch ein Virtual Being direkt in der App auf dem Smartphone läuft? Der Beichtvater für die Hosentasche?

Noch vor einem Jahr hätte ich gesagt: "Nein". Aber nach meinem Experiment glaube ich, dass es bestimmte Wege gäbe –, auch weil sich Cloudcomputing so weiterentwickelt hat. Nvidia, der weltweit größte Hersteller von Grafikkarten – die auch als Recheneinheiten für Deep Learning verwendet werden – berechnet mittlerweile grafisch aufwendige Spiele komplett in der Cloud und schickt das fertig berechnete Spielbild dann auf leistungsschwache Smartphones. Ich benutze für meine Forschung schon seit Langem Cloudcomputing. Das Tolle ist, in den vergangenen Jahren wurde es immer leichter, darauf zuzugreifen. Das heißt, wenn ich eine App habe, dann braucht sie nur Zugriff auf die Cloud. Eine solche App wäre innerhalb der nächsten zwei Jahre auf jeden Fall machbar – das könnte ich zur Not sogar selbst.

- Eigenes Interview