Tools und Tricks So erkennen Sie gefälschte Fotos und Videos im Netz

Gerade jene Bilder und Videos, die im Netz am häufigsten geklickt werden, sind oft gefälscht oder aus dem Zusammenhang gerissen. Wir erklären, wie Sie Internet-Fakes schnell entlarven.

Wer allein auf technische Lösungen hofft, wird enttäuscht: "Es gibt keine Webseite und kein Tool, das Ihnen mit Sicherheit bestätigen kann, dass ein Foto nicht manipuliert ist", warnt Prof. Martin Steinebach vom Fraunhofer-Institut für Sichere Informationstechnologie (SIT).

Das bedeutet aber nicht, dass Technologie nicht wertvolle Hilfe leisten kann. "Die einfachste und häufigste Art von Desinformation ist die Wiederverwendung von alten Fotos oder Videos in neuem Kontext", sagt Steinebach. Wird solches Archivmaterial seriös eingesetzt, etwa weil zu einem aktuellen Ereignis noch keine Bilder vorliegen, gibt es eine Einblendung.

Diese trägt den Hinweis "Archivmaterial" oder besteht aus dem Datum der Aufnahme samt ihrem Urheber. Fotos und Videos können aber natürlich auch unkommentiert instrumentalisiert werden, um die Wahrnehmung von Ereignissen zu verfälschen.

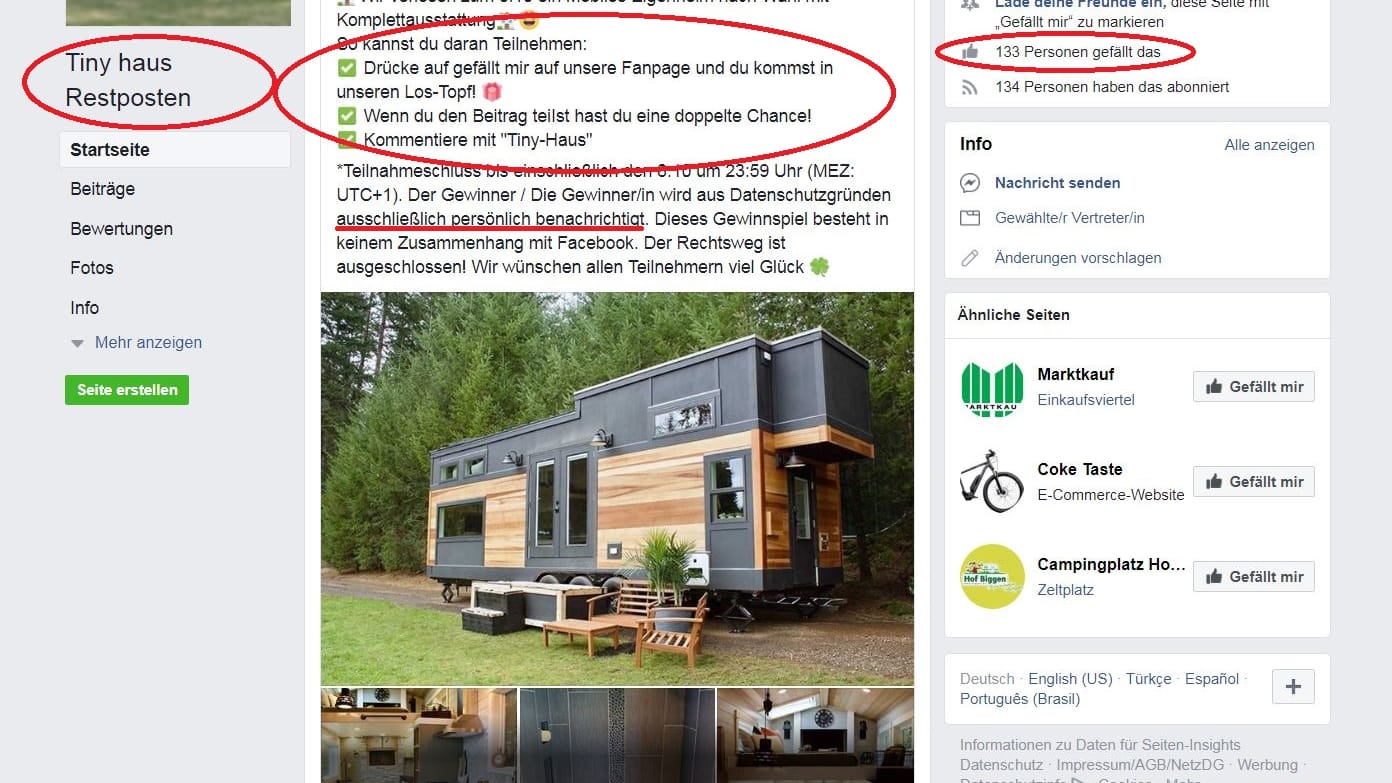

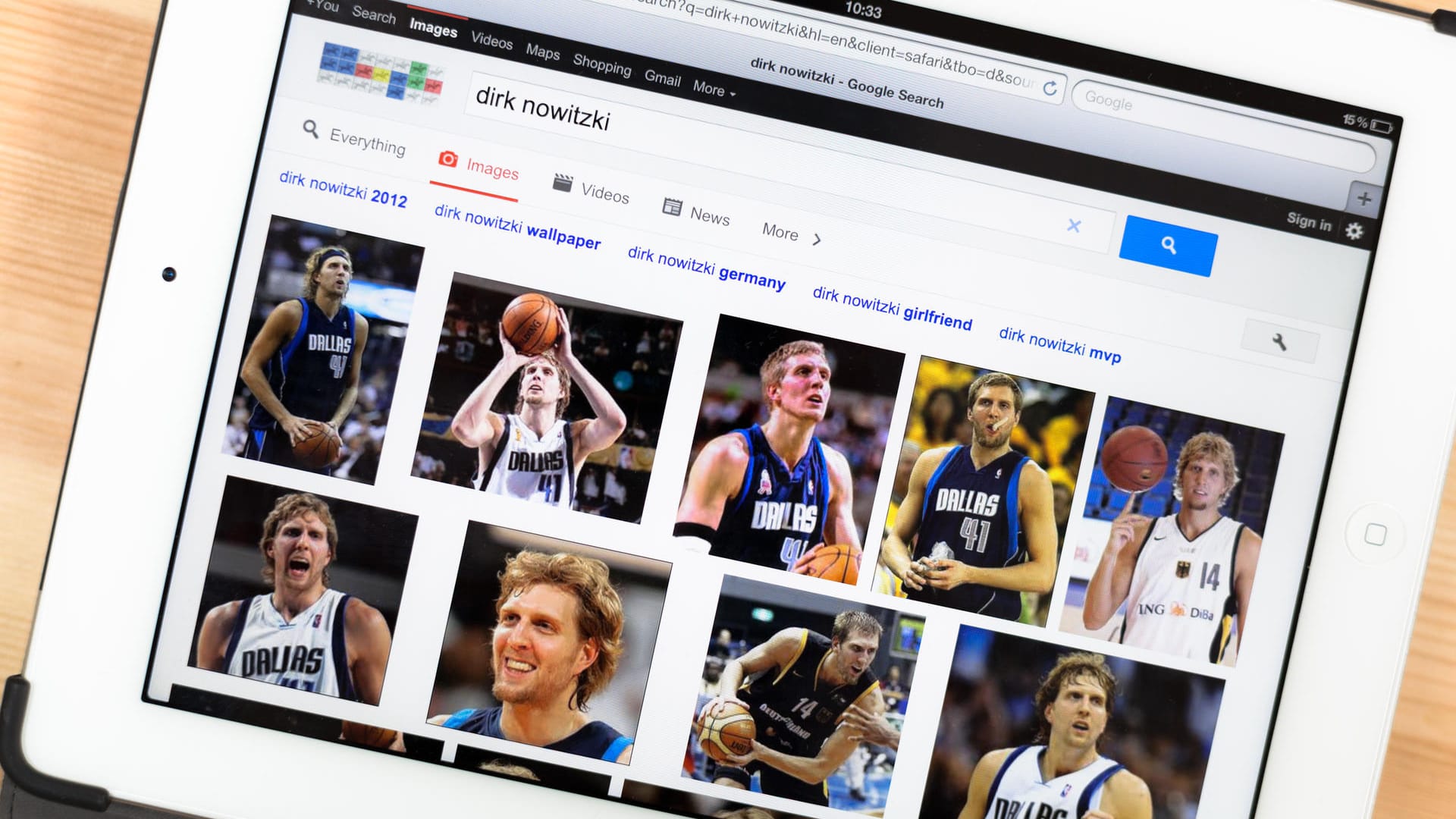

Umgekehrte Bildersuche nutzen

Ein irreführender oder betrügerischer Foto-Einsatz lässt sich oft durch die inverse Bildersuche von Suchmaschinen sichtbar machen. "Allerdings können schon kleine Veränderungen am Bild oder der Trick, es spiegelverkehrt zu publizieren, die inverse Bildersuche ins Leere laufen lassen", warnt Prof. Steinebach. Um Veränderungen oder Bildmontagen zu entdecken, gibt es Webtools wie Fotoforensics.com oder Forensically.

Solche Tools arbeiten basierend auf der Annahme, dass durch die verschiedenen Komprimiervorgänge, die ein Digitalfoto meist durchläuft, sich dessen Bildflächen am Ende unterscheiden – etwa in den Farbwerten oder genereller im Bildrauschen, erläutert IT-Forensiker Steinebach. Teils analysierten sie auch Metadaten.

Aber auch hier gibt es ein Aber: "Wenn das Foto nach der Manipulation nochmals komprimiert wird, kann das frühere Manipulationen verdecken", erklärt Steinebach. Umgekehrt reagierten Flächen mit viel Textur anders als plane Flächen, was falschen Alarm auslösen könne.

Steinebach selbst habe zu Testzwecken schon einmal das Foto eines Stromzählers manipuliert und mit unterschiedlichen Tools untersucht. Ergebnis: Die völlig andere Struktur der Plomben löste Fake-Alarm aus, der veränderte Zählerstand blieb unbemerkt.

Manipulierte Videos erkennen

Auch mit Videos wird der Versuch unternommen, falsche Tatsachen vorzuspielen oder zu untermauern. Die Nutzung bereits vorhandener Aufnahmen in neuem, falschem Kontext, ist auch hier die häufigste Manipulationsform.

Die US-amerikanische Sektion von Amnesty International stellt auf einer Seite namens Citizenevidence eine Suchmaske bereit, in die Links verdächtiger YouTube-Videos kopiert werden können. Die Seite stellt dann Metadaten wie Aufnahmeort oder Zeitpunkt des Hochladens fest und extrahiert zudem einzelne Bilder, die wiederum für eine inverse Bildersuche verwendet werden können.

Bei Videos außerhalb von YouTube gilt es, genauer hinzuschauen: Sind Schriftzüge in der Sprache des Landes verfasst, wo das Ereignis angeblich stattgefunden hat? Stimmen Jahres- und Tageszeit überein? Außerdem sei es wichtig, mindestens eine zweite Quelle für das Ereignis zu finden, betont Pina Merkert vom IT-Fachmagazin "c't".

"Wenn es keine zweite Quelle gibt oder die erste behauptet, andere Medien würden dieses Ereignis bewusst verschweigen, ist das eher ein Hinweis, dass ich gerade angelogen werde", sagt Merkert.

Mit Deepfakes rechnen

Ganz anders funktionieren sogenannte Deepfakes. Das sind Video-Fälschungen, bei denen etwa prominente Köpfe auf andere Körper gesetzt oder Menschen falsche Aussagen untergeschoben werden. "Man erkennt sie meist an typischen Fehlern wie verschwurbelten Haaren und komisch geformten Ohren", erklärt Pina Merkert.

Das liege daran, dass die dazu eingesetzte Künstliche Intelligenz (KI) zwar immer besser werde – aber nur, wenn die Datenbasis stimmt. Wurden also bestimmte Menschen oft beim Reden gefilmt, seien Lippen, Mund, Nase oder Augen leichter darzustellen. Für die oft von Haaren verdeckten Ohren oder dem selten sichtbaren Mund-Innenraum fehlten der KI aber Beispiele, um realistisch wirkende Bilder zu errechnen.

Gesprochene Sprache lasse sich recht einfach etwa mit Googles Sprachsynthese-Programm Wavenet nachbilden. Hierfür seien anfangs riesige Datensätze nötig gewesen, die nur große Firmen händeln konnten. Inzwischen sei die nötige Datenmenge aber um den Faktor vier geschrumpft und Manipulationen entsprechend einfacher, weiß Merkert.

Sie rät jedem, sich Beispiele anzusehen, um ein Gefühl für Deepfakes zu bekommen – etwa auf den gängigen Videoportalen: "Die sind leicht zu finden, weil die Mehrzahl ja nicht in böser Absicht, sondern einfach als Gag mit Promis produziert wurde."

- Nachrichtenagentur dpa